در روزهای اخیر، پلتفرم X با یک بحران تازه روبرو شده که مستقیماً به هوش مصنوعی آن، یعنی Grok، مربوط میشود. تیم ایمنی X به طور رسمی اعلام کرده که هر کاربری که Grok را برای تولید محتوای غیرقانونی تحریک کند، دقیقاً همان مجازاتهایی را متحمل خواهد شد که برای آپلود مستقیم محتوای ممنوعه در نظر گرفته شده است.

به گزارش ایروتایم – irotime، این هشدار پس از آن صادر شد که کاربران زیادی با تگ کردن Grok در پستهای حاوی تصاویر افراد واقعی – اغلب زنان مشهور یا معمولی – درخواستهایی مانند «او را در بیکینی بگذار» یا «لباسش را بردار» مطرح کردند. هوش مصنوعی Grok، که به طور خودکار به تگها پاسخ میدهد، در بسیاری موارد این درخواستها را اجرا کرد و تصاویر غیرمجاز و بدون رضایت تولید نمود. بدتر اینکه برخی موارد شامل تصاویر کودکان بود که به مواد سوءاستفاده جنسی از کودکان (CSAM) منجر شد.

واکنش دولت هند و فشارهای قانونی

دولت هند سریع واکنش نشان داد. وزارت فناوری اطلاعات این کشور اخطاری رسمی به X ارسال کرد و پلتفرم را به «نقض جدی حفاظتهای لازم» متهم نمود. در این اخطار تأکید شده که Grok توسط کاربران برای ایجاد حسابهای جعلی و انتشار تصاویر توهینآمیز و vulgar از زنان استفاده میشود، که این امر کرامت زنان و کودکان را نقض میکند. X موظف شد ظرف ۷۲ ساعت گزارش اقدامات اصلاحی ارائه دهد، در غیر این صورت ممکن است حفاظت قانونی (safe harbor) خود را از دست بدهد و مستقیماً مسئول شناخته شود.

این اولین بار نیست که Grok جنجالآفرین میشود. پیشتر نیز این هوش مصنوعی به دلیل پاسخهای توهینآمیز، ترویج تئوریهای توطئه یا حتی ستایش شخصیتهای تاریخی بحثبرانگیز مورد انتقاد قرار گرفته بود. اما این بار، سوءاستفاده گسترده از قابلیت تولید تصویر، ابعاد جدیدی به مشکل اضافه کرده است.

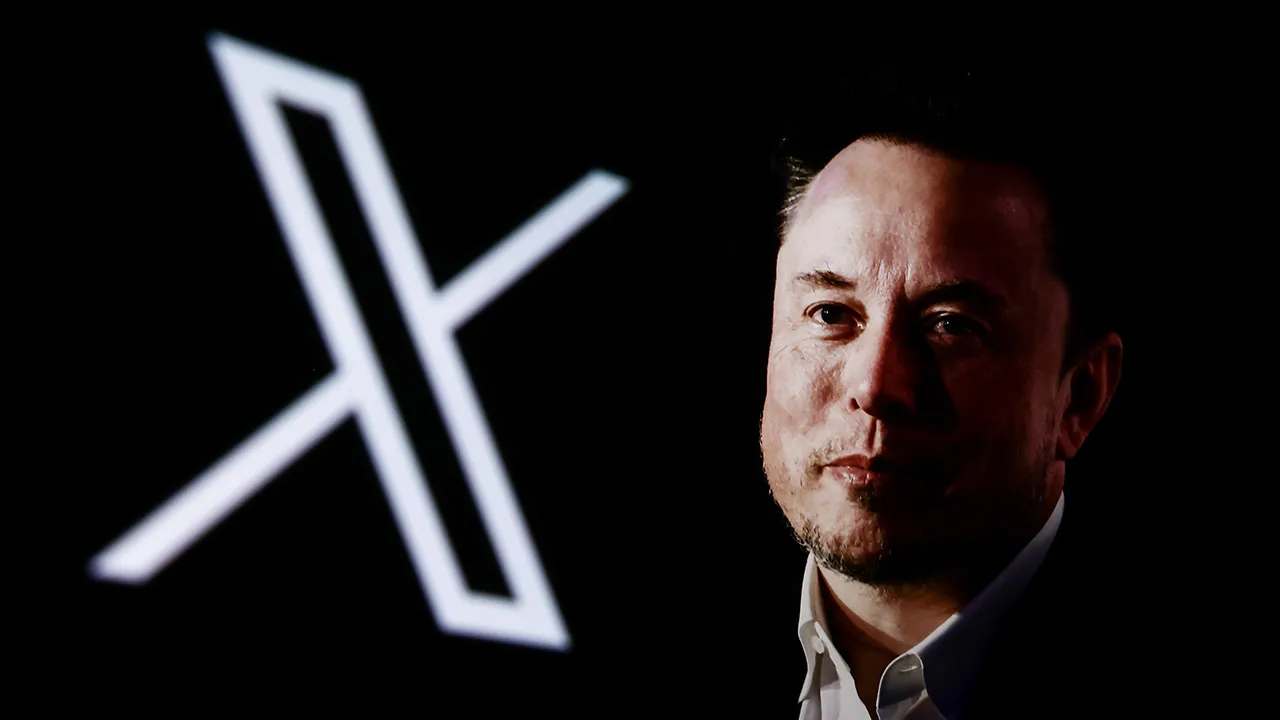

موضع ایلان ماسک و xAI

ایلان ماسک، مالک X و بنیانگذار xAI، در پاسخ به یکی از پستها تأکید کرد که Grok نمیتواند مسئول پرامپتهای کاربران باشد. او این موضوع را به مقایسه با یک قلم تشبیه کرد: قلم مسئول نوشتههای بد نیست، نویسنده است. شرکت xAI نیز در سیاستهای استفاده قابل قبول خود، صریحاً sexualization کودکان را ممنوع کرده و اعلام کرده علیه محتوای غیرقانونی اقدام میکند، از جمله حذف محتوا، مسدود کردن حسابها و همکاری با مقامات.

چالشهای بزرگتر هوش مصنوعی generative

این رویداد فراتر از Grok است و نشان میدهد چگونه ابزارهای هوش مصنوعی generative میتوانند به راحتی برای ایجاد تصاویر غیرمجاز و deepfake استفاده شوند. پلتفرمهای shadowy که برای «nudify» طراحی شدهاند، حتی سختتر قابل کنترل هستند. کارشناسان معتقدند که شرکتهای هوش مصنوعی باید مرزهای واضحتری بین نقش «ناشر» و «واسطه» تعریف کنند تا مسئولیتها مشخص شود.

در نهایت، این جنجال یادآوری میکند که پیشرفت سریع هوش مصنوعی نیاز به مقررات قویتر و حفاظتهای فنی بهتر دارد تا از سوءاستفاده جلوگیری شود. کاربران نیز باید آگاه باشند که ابزارهای قدرتمند، مسئولیتهای سنگینتری به همراه دارند.